Estudio de caso: Moderación de contenido

Más de 30 XNUMX documentos web eliminados y anotados para la moderación de contenido

que se esfuerzan por asegurar el espacio en línea donde nos conectamos y comunicamos.

A medida que crece el uso de las redes sociales, la

El problema del ciberacoso ha surgido como

obstáculo importante para las plataformas que se esfuerzan por

garantizar un espacio en línea seguro. un asombroso

38% de las personas encuentran esto

conducta perjudicial a diario,

haciendo hincapié en la urgente demanda de inventiva

enfoques de moderación de contenido.

Las organizaciones de hoy confían en el uso de

inteligencia artificial para hacer frente a la perdurable

proactivamente el problema del ciberacoso.

La seguridad cibernética:

Se revela el informe de cumplimiento de estándares comunitarios del cuarto trimestre de Facebook: acción en 4 millones de piezas de contenido de intimidación y acoso, con una tasa de detección proactiva del 6.3 %

EDUCACION:

A 2021 estudio encontró que 36.5%% de los estudiantes en los estados unidos entre las edades de 12 y 17 años experimentaron ciberacoso en un momento u otro durante su escolarización.

Según un informe de 2020, el mercado global de soluciones de moderación de contenido se valoró en USD 4.07 millones en 2019 y se esperaba que alcanzara los USD 11.94 millones para 2027, con una CAGR del 14.7 %.

Solución del mundo real

Datos que moderan las conversaciones globales

El cliente estaba desarrollando un robusto sistema automatizado

moderación de contenido Aprendizaje automático

modelo para su oferta en la nube, para la cual

estaban buscando un proveedor de dominio específico que

podría ayudarlos con datos de entrenamiento precisos.

Aprovechando nuestro amplio conocimiento en el procesamiento del lenguaje natural (PNL), ayudamos al cliente a recopilar, categorizar y anotar más de 30,000 XNUMX documentos en inglés y español para crear un modelo de aprendizaje automático de moderación de contenido automatizado bifurcado en contenido tóxico, para adultos o sexualmente explícito categorías.

Problema

- Web scraping de 30,000 documentos en español e inglés de dominios priorizados

- Categorización del contenido recopilado en segmentos cortos, medianos y largos

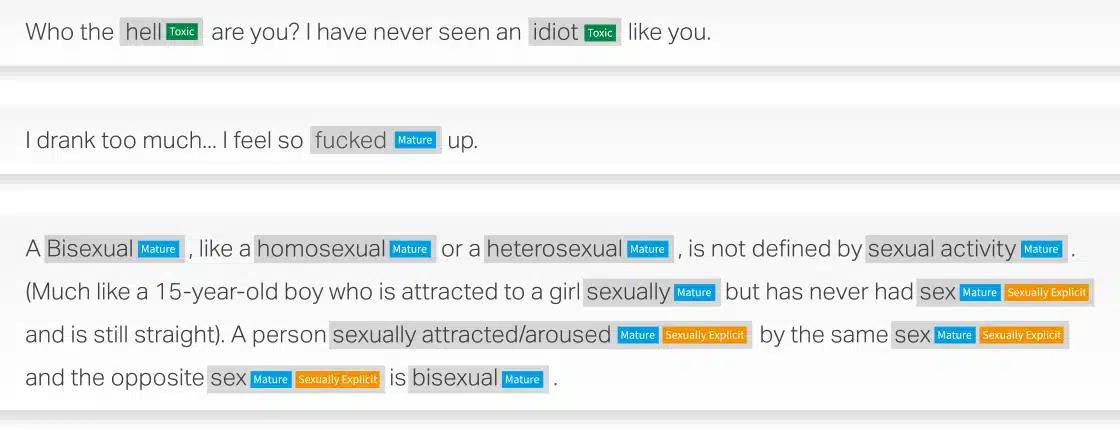

- Etiquetar los datos recopilados como contenido tóxico, para adultos o sexualmente explícito

- Asegurando anotaciones de alta calidad con un mínimo de 90% de precisión.

Solución

- Web Descartó 30,000 documentos cada uno para español e inglés de BFSI, Salud, Manufactura, Venta al por menor. El contenido se dividió aún más en documentos cortos, medianos y largos.

- Etiquetado exitoso del contenido clasificado como contenido tóxico, para adultos o sexualmente explícito

- Para lograr una calidad del 90 %, Shaip implementó un proceso de control de calidad de dos niveles:

» Nivel 1: Control de Garantía de Calidad: 100% de los archivos a validar.

» Nivel 2: Verificación de análisis de calidad crítica: el equipo CQA de Shaips evaluará entre el 15 % y el 20 % de las muestras retrospectivas.

Resultado

Los datos de capacitación ayudaron a construir un modelo de aprendizaje automático de moderación de contenido automatizado que puede generar varios resultados beneficiosos para mantener un entorno en línea más seguro. Algunos de los resultados clave incluyen:

- Eficiencia para procesar una gran cantidad de datos

- Coherencia para garantizar la aplicación uniforme de las políticas de moderación

- Escalabilidad para adaptarse a la creciente base de usuarios y volúmenes de contenido

- La moderación en tiempo real puede identificar y

eliminar contenido potencialmente dañino a medida que se genera - Rentabilidad al reducir la dependencia de moderadores humanos

Ejemplos de moderación de contenido

Cuéntenos cómo podemos ayudarlo con su próxima iniciativa de IA.