Hoy en día, más de 5.19 mil millones de personas exploran Internet. Esa es una audiencia enorme, ¿no?

El enorme volumen de contenido generado en Internet es nada menos que asombroso. Desde actualizaciones de redes sociales y publicaciones de blogs hasta comentarios generados por usuarios y cargas multimedia, el mundo en línea es un depósito de información vasto y dinámico.

Sin embargo, no todo el contenido es bueno. Algunos pueden ofender a varios grupos debido a su edad, raza, género, nacionalidad u origen étnico. Este tipo de contenido necesita una vigilancia cuidadosa. Esto garantiza la paz y la armonía para todos.

De ahí la necesidad apremiante de moderar el contenido. Aunque la revisión manual es efectiva, existen ciertas limitaciones que no podemos ignorar. Y ahí es donde la moderación automatizada de contenido entra en juego como una solución eficaz. Este método eficaz garantiza experiencias seguras en línea y protege a los usuarios de posibles daños.

En este artículo, hablaremos sobre los invaluables beneficios y los diversos tipos disponibles en las herramientas de moderación automatizada (preentrenadas con conjuntos de datos sólidos).

Comprensión de la moderación de contenido automatizada

La moderación de contenido automatizada utiliza tecnología para supervisar y administrar el contenido generado por el usuario. En lugar de que los humanos escaneen cada publicación, los algoritmos y el aprendizaje automático hacen el trabajo pesado. Identifican rápidamente contenido dañino o inapropiado. Estos sistemas aprenden de vastos conjuntos de datos y toman decisiones basadas en criterios establecidos previamente entrenados con humanos en el circuito.

Los métodos automatizados de moderación de contenido pueden ser muy eficientes. Trabajan las XNUMX horas del día y revisan instantáneamente grandes volúmenes de contenido. Sin embargo, también complementan a los revisores humanos. A veces, un toque humano es esencial para el contexto. Esta combinación garantiza espacios en línea más seguros a medida que los usuarios obtienen lo mejor de ambos mundos.

¿Quieres una plataforma libre de contenido dañino? La moderación automatizada de contenidos es el camino a seguir. Lo dejaremos más claro a medida que lea los tipos y beneficios a continuación.

[También lea: La guía necesaria para la moderación de contenidos]

Tipos de moderación automatizada

La moderación automatizada de contenidos ha evolucionado considerablemente a lo largo de los años. Ahora incorpora un espectro de tecnologías y enfoques, cada uno diseñado para satisfacer necesidades específicas. He aquí un vistazo más de cerca a los diferentes tipos:

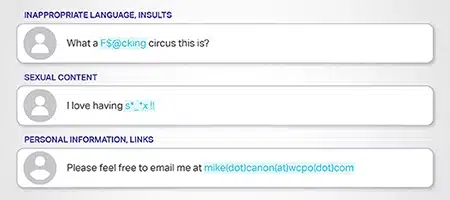

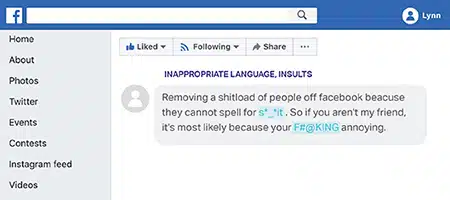

Moderación basada en palabras clave

Este método funciona con listas predefinidas de palabras prohibidas o marcadas. Cuando el contenido contiene estas palabras, el sistema niega su publicación o lo envía a revisión. Por ejemplo, las plataformas pueden bloquear lenguaje explícito o términos vinculados al discurso de odio.

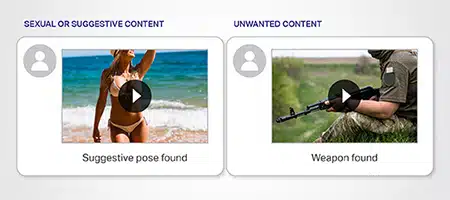

Moderación del reconocimiento de imágenes

Aprovechando el poder del aprendizaje automático, este método identifica imágenes inapropiadas o marcadas. Puede detectar imágenes que promuevan la violencia, contenido explícito o materiales protegidos por derechos de autor. Algoritmos avanzados analizan patrones visuales para asegurarse de que ninguna imagen dañina pase desapercibida.

Moderación del análisis de vídeo

De manera similar al reconocimiento de imágenes, el análisis de video desglosa los componentes del video cuadro por cuadro. Comprueba si hay imágenes, señales de audio o contenido marcado inapropiados. Es invaluable en plataformas como YouTube donde domina el contenido de video.Moderación del análisis de sentimiento

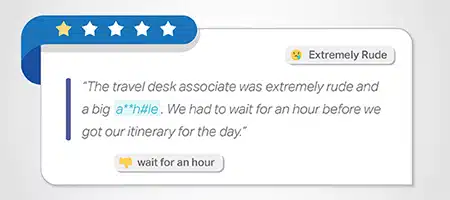

Comprender el sentimiento o la emoción detrás del contenido es vital. Este método evalúa el tono del contenido y señala el contenido que es demasiado negativo, promueve el odio o fomenta sentimientos dañinos. Es particularmente útil en foros o plataformas que promueven interacciones comunitarias positivas.

Moderación contextual

El contenido a menudo requiere contexto para una moderación precisa. Este método evalúa el contenido dentro de su contexto circundante. Garantiza que el contenido genuino, incluso con palabras marcadas, no se bloquee erróneamente si el contexto general es inofensivo. En el ejemplo, contiene la palabra "matar", en contexto, es benigna y se refiere a la actividad inofensiva de jugar.

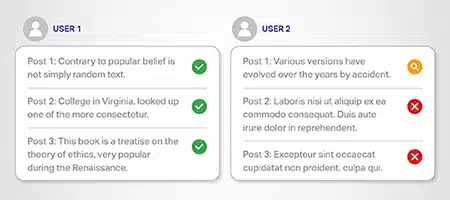

Moderación basada en la reputación del usuario

Los usuarios con un historial de violación de las pautas podrían merecer un escrutinio más detenido. Este sistema modera según la reputación del usuario. Aquellos con infracciones anteriores pueden encontrar que su contenido se revisa más estrictamente que aquellos con borrón y cuenta nueva.

Moderación de monitoreo de redes sociales

Dada la gran cantidad de contenidos generados en las redes sociales, herramientas especializadas monitorean estas plataformas. Detectan problemas potenciales como desinformación, noticias falsas o trolling en tiempo real. Ayuda a crear un entorno de redes sociales más limpio y seguro.

Beneficios de la moderación automatizada

La automatización trae consigo varios beneficios. Echemos un vistazo más de cerca a los beneficios que ofrece la moderación automatizada de contenido:

Filtrado de contenido eficiente

Con el aumento del contenido generado por el usuario (CGU), las plataformas necesitan sistemas para examinar grandes cantidades. Ofertas de moderación de contenido automatizada filtrado de contenido eficiente. Garantiza que sólo los materiales adecuados vean la luz.

Seguridad digital mejorada

La seguridad en línea es importante para aumentar la confianza de los usuarios al utilizar Internet. La automatización ayuda a mantener la seguridad digital al detectar contenido dañino. Desde discursos de odio hasta acoso en línea, mantiene a raya esas amenazas.

Cumplimiento de las pautas de la comunidad

Las pautas de la comunidad mantienen la integridad de la plataforma. La automatización garantiza que estas reglas no se infrinjan y ayuda a crear espacios armoniosos en línea.

Luchar contra el acoso y el discurso de odio en línea

Los sistemas automatizados pueden identificar y eliminar rápidamente el acoso y el discurso de odio en línea. Garantizan que las plataformas sigan siendo acogedoras y seguras al marcar contenido dañino.

Abordar la desinformación y las noticias falsas

En la época de desinformación rampante, la automatización juega un papel fundamental. Detecta y suprime la desinformación y las noticias falsas para defender la verdad y la precisión.

Abordar el trolling

El trolling puede arruinar los diálogos en línea y descarrilar conversaciones significativas. La moderación de contenido automatizada detecta a estos trolls y ayuda a mantener un ambiente positivo. Imagínese un salón de clases. La TI actúa como esa fuerza cautelosa que promueve interacciones constructivas y brinda a los usuarios una mejor experiencia.

Análisis en profundidad

El análisis de texto va más allá de la mera detección de palabras clave. Entiende el contexto y promueve contenido genuino al tiempo que elimina narrativas dañinas. Más allá de los textos, las herramientas de reconocimiento de imágenes detectan imágenes inapropiadas. Garantizan que las imágenes se alineen con los estándares de la plataforma.

Moderación integral de videos

El contenido de vídeo domina el espacio digital ya que a la gente le encantan las imágenes atractivas. La automatización interviene para garantizar que estos videos cumplan con estándares específicos. Examina volúmenes masivos de contenido, detecta elementos dañinos y los elimina rápidamente.

Conclusión

La moderación automatizada de contenido presenta tanto beneficios como desafíos. Destaca en la eliminación de contenido inadecuado de plataformas digitales. Sin embargo, también enfrenta limitaciones y suscita debates sobre la censura y el papel de la tecnología. En muchos casos, también se requiere la moderación experta de los humanos en caso de ambigüedad.

Las plataformas deben tener claras las reglas de moderación. También necesitan sistemas para que los usuarios cuestionen las decisiones de eliminación de contenido en busca de equidad y precisión. Con el equilibrio adecuado, podemos lograr justicia para los usuarios en línea manteniendo al mismo tiempo su seguridad y defendiendo sus derechos.

Este método funciona con listas predefinidas de palabras prohibidas o marcadas. Cuando el contenido contiene estas palabras, el sistema niega su publicación o lo envía a revisión. Por ejemplo, las plataformas pueden bloquear lenguaje explícito o términos vinculados al discurso de odio.

Este método funciona con listas predefinidas de palabras prohibidas o marcadas. Cuando el contenido contiene estas palabras, el sistema niega su publicación o lo envía a revisión. Por ejemplo, las plataformas pueden bloquear lenguaje explícito o términos vinculados al discurso de odio. Aprovechando el poder del aprendizaje automático, este método identifica imágenes inapropiadas o marcadas. Puede detectar imágenes que promuevan la violencia, contenido explícito o materiales protegidos por derechos de autor. Algoritmos avanzados analizan patrones visuales para asegurarse de que ninguna imagen dañina pase desapercibida.

Aprovechando el poder del aprendizaje automático, este método identifica imágenes inapropiadas o marcadas. Puede detectar imágenes que promuevan la violencia, contenido explícito o materiales protegidos por derechos de autor. Algoritmos avanzados analizan patrones visuales para asegurarse de que ninguna imagen dañina pase desapercibida.

Comprender el sentimiento o la emoción detrás del contenido es vital. Este método evalúa el tono del contenido y señala el contenido que es demasiado negativo, promueve el odio o fomenta sentimientos dañinos. Es particularmente útil en foros o plataformas que promueven interacciones comunitarias positivas.

Comprender el sentimiento o la emoción detrás del contenido es vital. Este método evalúa el tono del contenido y señala el contenido que es demasiado negativo, promueve el odio o fomenta sentimientos dañinos. Es particularmente útil en foros o plataformas que promueven interacciones comunitarias positivas. El contenido a menudo requiere contexto para una moderación precisa. Este método evalúa el contenido dentro de su contexto circundante. Garantiza que el contenido genuino, incluso con palabras marcadas, no se bloquee erróneamente si el contexto general es inofensivo. En el ejemplo, contiene la palabra "matar", en contexto, es benigna y se refiere a la actividad inofensiva de jugar.

El contenido a menudo requiere contexto para una moderación precisa. Este método evalúa el contenido dentro de su contexto circundante. Garantiza que el contenido genuino, incluso con palabras marcadas, no se bloquee erróneamente si el contexto general es inofensivo. En el ejemplo, contiene la palabra "matar", en contexto, es benigna y se refiere a la actividad inofensiva de jugar. Los usuarios con un historial de violación de las pautas podrían merecer un escrutinio más detenido. Este sistema modera según la reputación del usuario. Aquellos con infracciones anteriores pueden encontrar que su contenido se revisa más estrictamente que aquellos con borrón y cuenta nueva.

Los usuarios con un historial de violación de las pautas podrían merecer un escrutinio más detenido. Este sistema modera según la reputación del usuario. Aquellos con infracciones anteriores pueden encontrar que su contenido se revisa más estrictamente que aquellos con borrón y cuenta nueva. Dada la gran cantidad de contenidos generados en las redes sociales, herramientas especializadas monitorean estas plataformas. Detectan problemas potenciales como desinformación, noticias falsas o trolling en tiempo real. Ayuda a crear un entorno de redes sociales más limpio y seguro.

Dada la gran cantidad de contenidos generados en las redes sociales, herramientas especializadas monitorean estas plataformas. Detectan problemas potenciales como desinformación, noticias falsas o trolling en tiempo real. Ayuda a crear un entorno de redes sociales más limpio y seguro.