El mundo digital está en constante evolución, y un catalizador que diferencia esta plataforma de las demás es contenido generado por el usuario. Aunque las empresas de todo el mundo tienen sus sitios web y una presencia dedicada en las redes sociales, es más probable que los usuarios confíen en las opiniones de sus compañeros clientes que en las palabras de la empresa.

Más de 4.26 millones de personas eran usuarios activos de las redes sociales en 2021. Se predijo que un número tocaría la marca de los 6 mil millones para 2027. La cantidad de contenido generado, capturado, compartido y consumido a escala global alcanzó los 64.2 zettabytes en 2020.

Con la generación y el consumo de nuevo contenido a un ritmo vertiginoso, se ha vuelto esencial que las marcas controlen el contenido alojado en sus plataformas. Plataformas en línea debe ser y seguir siendo un entorno seguro para sus usuarios.

[También lea: Comprensión de la moderación de contenido automatizada]

¿Qué es la moderación de contenido y por qué?

El contenido generado por el usuario impulsa las plataformas de redes sociales y moderación de contenido se refiere a filtrar este contenido en busca de publicaciones inapropiadas u ofensivas. Las plataformas comerciales y de redes sociales tienen un estándar específico para monitorear su contenido de alojamiento.

Las directrices podrían incluir cualquier cosa, desde violencia, extremismo, el discurso del odio, desnudez, infracción de derechos de autor o cualquier cosa ofensiva. El contenido publicado se marcará y eliminará si no cumple con el estándar.

La idea detrás de la moderación de contenido es garantizar que el contenido esté en sintonía con los ideales de la marca y defienda los valores de decencia, confianza y seguridad.

La moderación del contenido es crucial para que las empresas mantengan los estándares comerciales, la imagen de marca, la reputación y la credibilidad. Cada segundo, la asombrosa cantidad de contenido generado por los usuarios que se publica en las plataformas dificulta que las marcas se mantengan alejadas de contenido ofensivo y contenido inapropiado, texto, videos e imágenes. La estrategia de moderación de contenido ayuda a las marcas a mantener su imagen al tiempo que permite a los usuarios expresarse y cerrar el contenido ofensivo, explícito y violento.

¿Qué tipos de contenido puedes moderar?

Los algoritmos de moderación de contenido generalmente se ocupan de tres o una combinación de estos tipos de contenido.

Texto

La gran cantidad de texto, desde comentarios hasta artículos completos, que necesita moderación es bastante asombrosa. Las publicaciones de texto están disponibles en casi cualquier lugar en forma de comentarios, artículos, publicaciones en foros, debates en redes sociales y otras publicaciones.

Los algoritmos de moderación de contenido de texto deberían poder escanear el texto de diferentes longitudes y estilos en busca de contenido no deseado. Además, la moderación de textos puede ser una tarea difícil debido a las complejidades del idioma y los matices culturales.

Imágenes

La moderación de imágenes es mucho más simple que la moderación de texto, pero es esencial contar con pautas o estándares adecuados.

Además, dado que las diferencias culturales pueden entrar en juego al moderar las imágenes, es crucial comprender a fondo y conectarse con la comunidad de usuarios en varias ubicaciones geográficas.

Videos

Moderar contenido de video es muy difícil, ya que moderar videos puede llevar mucho tiempo, a diferencia del texto o las imágenes. El moderador debe ver el video completo antes de considerarlo apto o no apto para el consumo. Incluso si solo unos pocos cuadros en el video son explícitos o perturbadores, obligará al moderador a eliminar todo el contenido.

Retransmisiones en directo

La transmisión en vivo es, quizás, el contenido más desafiante para moderar. Esto se debe a que la moderación del video y el texto que lo acompaña debe ocurrir simultáneamente con la transmisión.

¿Cómo funciona la moderación de contenido?

Para comenzar a moderar el contenido de su plataforma, primero debe establecer estándares o pautas que determinen el contenido inapropiado. Estas pautas ayudan a los moderadores a marcar el contenido para su eliminación.

Defina el nivel de sensibilidad o el umbral de contenido que los moderadores deben tener en cuenta al revisar el contenido. El umbral debe definirse en función de su marca, el tipo de negocio, las expectativas del usuario y la ubicación.

Tipos de moderación de contenido

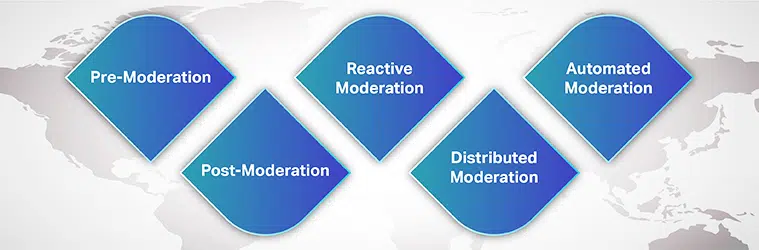

Puedes elegir entre muchos procesos de moderación para las necesidades de su marca y consentimiento del usuario. Algunos de ellos son:

Moderación previa

Antes de que el contenido se muestre en su sitio, está en la cola de moderación. Solo después de que el contenido se revisa y se considera apto para el consumo, se publica en la plataforma. Aunque este es un método seguro para bloquear contenido explícito, requiere mucho tiempo.

Posmoderación

La moderación posterior es el método estándar de moderación de contenido en el que existe un equilibrio entre la participación del usuario y la moderación. Aunque los usuarios pueden publicar sus envíos, todavía está en cola para moderación. Si el contenido ha sido marcado, se revisa y elimina. Las empresas se esfuerzan por lograr un tiempo de revisión más corto para que el contenido inapropiado no permanezca en línea por mucho tiempo.

Moderación reactiva

En moderación reactiva, se alienta a la comunidad de usuarios a marcar contenido inapropiado que viola la comunidad. reglas y guías. En este método, la atención de la comunidad se dirige al contenido que necesita moderación. Sin embargo, el contenido ofensivo puede permanecer en la plataforma por períodos más prolongados.

Moderación distribuida

En un método de moderación distribuida, la comunidad en línea puede revisar, marcar y eliminar el contenido que encuentran ofensivo y en contra de las pautas mediante un sistema de clasificación.

Moderación automatizada

Como sugiere el nombre, la moderación automática utiliza varias herramientas y sistemas para marcar palabras o frases y rechazar envíos. Funciona filtrando ciertas palabras, imágenes y videos prohibidos mediante algoritmos de aprendizaje automático.

Aunque la moderación impulsada por la tecnología es cada vez más frecuente, moderación humana en revisión no puede ser ignorada. Idealmente, las empresas utilizan una combinación de herramientas automatizadas y moderadores humanos, al menos para situaciones complejas.

[También lea: Estudio de caso: moderación de contenido]

¿Cómo ayuda Machine Learning a la moderación de contenido?

Con más de 5 mil millones de personas que usan Internet y más de 4 mil millones activas en las redes sociales, no es fácil sorprenderse por la gran cantidad de imágenes, textos, videos, publicaciones y mensajes que se generan a diario. Este contenido gigantesco debe moderarse de alguna manera para que los usuarios que acceden a sus sitios de redes sociales puedan tener una experiencia agradable y enriquecedora.

La moderación de contenido surgió como la solución para eliminar contenido explícito, ofensivo, abusivo, fraudulento o contrario a la ética de la marca. Tradicionalmente, las empresas han confiado completamente en moderadores humanos para revisar el contenido generado por los usuarios en línea publicado en sus plataformas. Sin embargo, depender completamente de moderadores humanos puede hacer que el proceso lleve mucho tiempo, sea costoso e ineficiente.

Las empresas ahora están empleando algoritmos de aprendizaje automático para moderar el contenido de manera automática y eficiente. Alimentado por IA la moderación de contenido ha hecho que todo el proceso sea eficiente, más rápido, consistente y rentable.

Aunque este proceso no elimina la necesidad de moderadores humanos, humano-en-el-bucle, la contribución de los moderadores humanos ayuda a abordar problemas complejos. Además, los moderadores humanos comprenden mejor los matices del idioma, las diferencias culturales y el contexto. Cuando se utilizan herramientas automatizadas, con la ayuda de moderadores humanos, se reduce el impacto psicológico de la exposición al contenido desencadenante.

Desafíos de la moderación de contenido

Otro desafío importante cuando se trata de desarrollar un algoritmo de moderación de contenido preciso es el idioma. Una aplicación de moderación de contenido confiable debe ser capaz de reconocer varios idiomas y comprender los matices culturales, los contextos sociales y el dinamismo lingüístico.

Dado que un idioma pasa por varios cambios a lo largo del tiempo, ya que ciertas palabras que ayer eran inocentes podrían haber ganado notoriedad hoy, el modelo ML debe seguir el ritmo del mundo cambiante. Por ejemplo, un desnudo puede ser explícito y voyerista o simplemente arte.

Como un pieza de contenido se percibe o se considera inapropiado depende del contexto. Y es crucial tener consistencia y estándares dentro de su plataforma para que sus usuarios puedan confiar en sus esfuerzos de moderación.

Un usuario típico siempre intenta encontrar lagunas en sus pautas y eludir las reglas de moderación. Sin embargo, su algoritmo ML debería poder evolucionar con los tiempos cambiantes continuamente.

Finalmente, está la cuestión del sesgo. Es fundamental diversificar su base de datos de entrenamiento y sus modelos de entrenamiento para detectar el contexto. Aunque desarrollar un algoritmo de moderación de contenido confiable puede parecer un desafío, comienza con tener en tus manos conjuntos de datos de entrenamiento de alta calidad.

Los proveedores externos con los conocimientos y la experiencia adecuados en la entrega de conjuntos de datos de capacitación adecuados son el lugar adecuado para comenzar.

Toda empresa con presencia social necesita un equipo de vanguardia solución de moderación de contenido que ayuda a construir la confianza del cliente y una experiencia impecable del cliente. Para crear la aplicación y entrenar su modelo de aprendizaje automático, necesita acceso a una base de datos de alta calidad sin prejuicios, alineada con las últimas tendencias lingüísticas y de contenido específico del mercado.

Con nuestros años de experiencia ayudando a las empresas a lanzar modelos de IA, Saip ofrece sistemas integrales de recopilación de datos que satisfacen diversas necesidades de moderación de contenido.